Introdução: o desafio do armazenamento empresarial moderno O crescimento acelerado da virtualização, da análise de dados e dos fluxos colaborativos de mídia transformou o armazenamento em um elemento crítico da continuidade operacional. Em ambientes corporativos, o storage deixou de ser apenas um repositório passivo de dados para se tornar um componente ativo da infraestrutura de TI, diretamente responsável por desempenho, resiliência e segurança. Organizações que executam múltiplas máquinas virtuais, containers e workloads sensíveis enfrentam um desafio recorrente: garantir integridade absoluta dos dados enquanto sustentam alto throughput e baixa latência. Falhas de armazenamento, corrupção silenciosa ou indisponibilidade impactam diretamente a operação do negócio, gerando riscos financeiros e reputacionais difíceis de mitigar. A inação ou a adoção de soluções inadequadas resulta em gargalos de desempenho, janelas de indisponibilidade prolongadas e exposição crescente a ameaças como ransomware. Em cenários críticos, a ausência de snapshots consistentes, sincronização em tempo real ou mecanismos de failover pode comprometer totalmente a recuperação de dados. Nesse contexto, o QNAP TVS-h474 surge como uma plataforma NAS empresarial projetada para atender ambientes que exigem confiabilidade, escalabilidade e performance, combinando o sistema operacional QuTS hero baseado em ZFS com recursos avançados de virtualização, cache NVMe, alta disponibilidade e aceleração por IA. O problema estratégico: armazenamento confiável para workloads virtualizados A virtualização consolidou servidores, reduziu custos de hardware e aumentou a flexibilidade operacional. No entanto, esse avanço trouxe uma dependência extrema do subsistema de armazenamento. Cada máquina virtual compartilha o mesmo backend, tornando qualquer falha potencialmente sistêmica. Em ambientes onde múltiplas VMs são criadas a partir de templates semelhantes, o consumo de storage cresce rapidamente se não houver mecanismos eficientes de deduplicação e compressão. Além disso, operações de escrita aleatória, típicas de bancos de dados e sistemas virtualizados, exigem arquiteturas capazes de lidar com alta concorrência de I/O. O desafio estratégico está em equilibrar desempenho, proteção de dados e eficiência de armazenamento, sem introduzir complexidade excessiva na gestão. Soluções tradicionais baseadas apenas em RAID e backups periódicos já não são suficientes para atender a requisitos modernos de RPO e RTO. Consequências da inação Sem um sistema de arquivos robusto, a corrupção silenciosa de dados pode passar despercebida por longos períodos, sendo detectada apenas no momento da restauração. Esse cenário compromete a confiabilidade de backups e snapshots, criando uma falsa sensação de segurança. Além disso, a ausência de sincronização em tempo real entre sistemas ativos e passivos aumenta drasticamente o tempo de recuperação em caso de falha. Ambientes sem failover automatizado dependem de intervenções manuais, elevando o risco de indisponibilidade prolongada. Do ponto de vista financeiro, a necessidade de superdimensionar storage para compensar ineficiências resulta em maior custo total de propriedade, especialmente em cenários que adotam SSDs para desempenho. Fundamentos da solução: QuTS hero e o sistema de arquivos ZFS O QNAP TVS-h474 utiliza o sistema operacional QuTS hero, que combina a flexibilidade do ecossistema de aplicativos QNAP com o sistema de arquivos ZFS de 128 bits. Essa arquitetura foi projetada para ambientes que não podem tolerar inconsistências de dados. O ZFS adota um modelo de verificação ponta a ponta, garantindo que os dados gravados sejam exatamente os dados lidos. O mecanismo de auto-recuperação corrige automaticamente inconsistências detectadas, utilizando informações de paridade armazenadas no RAID Z. Além da integridade, o ZFS oferece tecnologias avançadas de redução de dados, incluindo deduplicação inline, compressão e compactação em nível de bloco. Essas funcionalidades são particularmente relevantes em ambientes virtualizados, onde múltiplas instâncias compartilham estruturas de dados semelhantes. Impacto direto nos negócios Ao reduzir drasticamente o consumo de storage, o TVS-h474 permite maior densidade de máquinas virtuais sem a necessidade de expansão imediata de hardware. O exemplo fornecido no material original demonstra que 20 VMs baseadas no mesmo template podem ter o consumo reduzido em até 95%. Essa eficiência não apenas reduz custos, mas também melhora o desempenho, já que menos dados precisam ser gravados e lidos fisicamente dos discos. Em soluções all-flash, esse comportamento contribui diretamente para o aumento da vida útil dos SSDs. Arquitetura de performance: CPU, memória e aceleração NVMe O TVS-h474 é equipado com um processador Intel® Pentium® Gold dual-core com clock de até 3.7 GHz, suportando quatro threads e integrado à GPU Intel® UHD Graphics 710. Essa combinação oferece capacidade adequada para multitarefa, virtualização leve e aceleração de mídia. A plataforma suporta até 64 GB de memória DDR4 em dual-channel, requisito essencial para ambientes que utilizam deduplicação inline, onde o próprio material recomenda no mínimo 16 GB, sendo 32 GB ideais para melhor desempenho. Do ponto de vista de I/O, os dois slots M.2 PCIe Gen 3 permitem a criação de cache NVMe ou pools de SSD dedicados. Essa arquitetura reduz significativamente a latência em workloads aleatórios e melhora o tempo de resposta de aplicações críticas. Trade-offs e considerações técnicas Embora a deduplicação ofereça ganhos expressivos de eficiência, ela exige maior consumo de memória e processamento. Organizações devem avaliar cuidadosamente o perfil de workload antes de habilitar essa funcionalidade, garantindo que o dimensionamento esteja alinhado às exigências operacionais. Da mesma forma, a utilização de NVMe como cache ou como volume do sistema operacional QuTS hero traz ganhos claros de desempenho, mas implica investimento adicional em SSDs compatíveis. Conectividade e escalabilidade: redes de alta velocidade O TVS-h474 oferece conectividade 2.5GbE nativa, permitindo ganhos imediatos de throughput utilizando cabos Cat 5e existentes. Para ambientes que demandam maior largura de banda, os slots PCIe Gen 4 permitem a instalação de adaptadores 5GbE, 10GbE ou 25GbE. Os testes realizados pela QNAP Labs demonstram throughput sequencial superior a 3.000 MB/s em leitura utilizando 25GbE, evidenciando a capacidade da plataforma para workloads intensivos de virtualização e backup. A flexibilidade de expansão garante que o investimento inicial possa ser preservado à medida que as demandas crescem, evitando a substituição completa do sistema. Alta disponibilidade e continuidade operacional Um dos diferenciais estratégicos do TVS-h474 é o suporte a arquitetura de alta disponibilidade com dois NAS. Nesse modelo, um sistema atua como servidor ativo enquanto o outro permanece passivo, sincronizando dados em tempo real. Em caso de

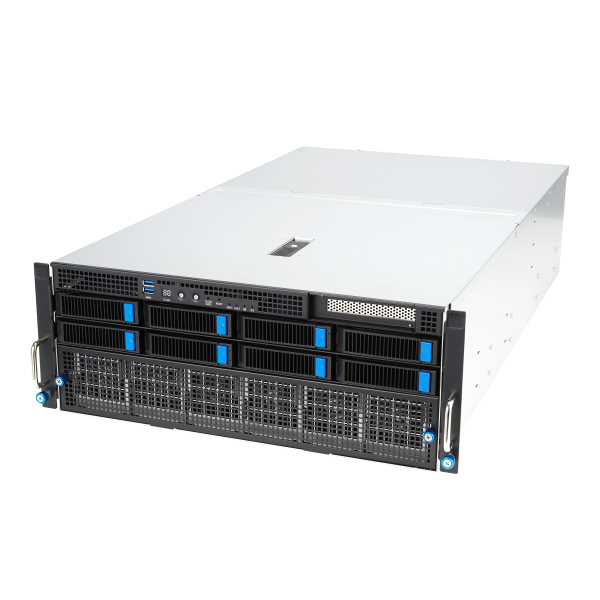

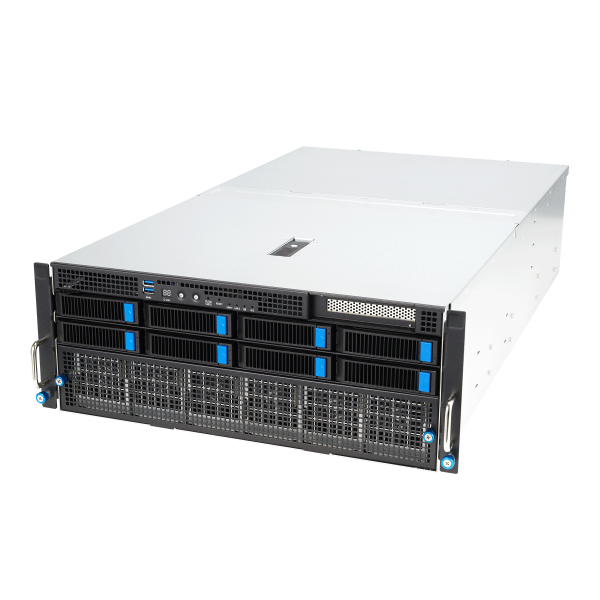

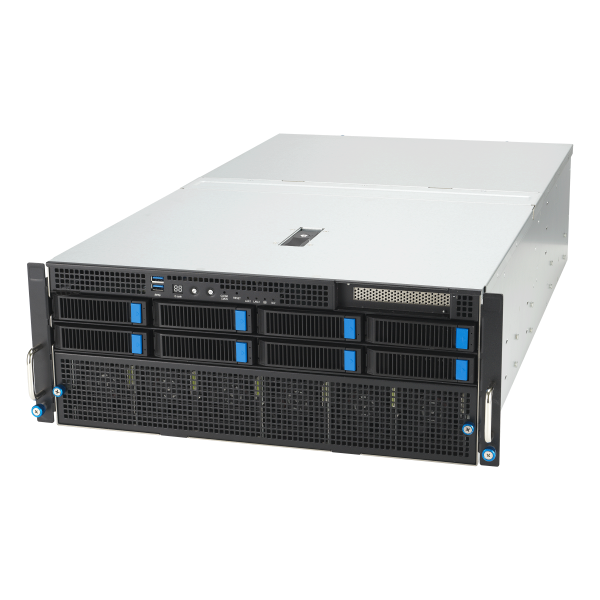

Introdução A crescente complexidade das cargas de trabalho empresariais modernas tem imposto um desafio estrutural aos data centers: como consolidar desempenho extremo, flexibilidade arquitetural e governança operacional em infraestruturas cada vez mais compactas. Virtualização em larga escala, armazenamento definido por software, inferência de IA, computação em nuvem e redes 5G não são mais silos isolados, mas workloads concorrentes que disputam recursos críticos de CPU, memória, I/O e energia. Nesse cenário, a escolha do servidor deixa de ser uma decisão puramente técnica e passa a ser uma escolha estratégica, com impacto direto na escalabilidade do negócio, no custo operacional e na resiliência do ambiente. Plataformas genéricas, sem suporte adequado a aceleração, memória de alta densidade e expansão PCIe moderna, rapidamente se tornam gargalos invisíveis. O SuperServer SYS-222HE-TN surge exatamente nesse ponto de tensão. Trata-se de um sistema rackmount 2U, de profundidade reduzida, projetado para atender ambientes empresariais que exigem alta densidade computacional, conectividade avançada e suporte a workloads heterogêneos, sem comprometer governança, segurança ou eficiência energética. Ao longo deste artigo, será analisada em profundidade a arquitetura, os fundamentos técnicos e os impactos estratégicos do SYS-222HE-TN, conectando suas capacidades a desafios reais de data centers corporativos e ambientes de missão crítica. O desafio estratégico da consolidação de workloads empresariais Problema estratégico Empresas que operam múltiplas cargas críticas enfrentam uma fragmentação estrutural crescente. Ambientes de virtualização demandam alta capacidade de memória e baixa latência. Plataformas de armazenamento definido por software exigem IOPS consistentes e conectividade NVMe. Inferência de IA e machine learning dependem de aceleração por GPU e largura de banda PCIe elevada. Redes 5G e edge computing, por sua vez, impõem restrições físicas e térmicas severas. Historicamente, esses requisitos eram atendidos por infraestruturas separadas. No entanto, essa abordagem eleva custos, aumenta a complexidade operacional e dificulta a governança unificada do ambiente. Consequências da inação A ausência de uma plataforma capaz de consolidar essas demandas resulta em subutilização de recursos, maior consumo energético e aumento do risco operacional. Além disso, servidores sem suporte a PCIe 5.0, memória DDR5 de alta densidade ou topologias flexíveis de expansão limitam a adoção de tecnologias emergentes. Fundamentos da solução O SYS-222HE-TN foi concebido como uma plataforma de consolidação. Seu design 2U de profundidade curta permite instalação em ambientes tradicionais e edge, enquanto sua arquitetura interna oferece suporte simultâneo a computação intensiva, aceleração e armazenamento de alto desempenho Arquitetura de processamento baseada em Intel Xeon 6700/6500 Base técnica O sistema suporta processadores Intel Xeon 6700/6500 em configuração dual socket E2 (LGA-4710), permitindo a escolha entre arquiteturas com P-cores ou E-cores, de acordo com o perfil do workload. Essa flexibilidade é fundamental em ambientes onde diferentes aplicações competem por recursos computacionais. Com até 86 núcleos e 172 threads por CPU em variantes com P-cores, ou até 144 núcleos por CPU em variantes com E-cores, o SYS-222HE-TN oferece uma base sólida para virtualização densa, computação em nuvem e processamento paralelo. Trade-offs arquiteturais A possibilidade de escolha entre P-cores e E-cores implica decisões estratégicas. Ambientes que priorizam desempenho por thread podem se beneficiar dos P-cores, enquanto cargas altamente paralelizáveis, como serviços em nuvem ou inferência distribuída, encontram nos E-cores uma alternativa eficiente em termos de densidade computacional. Considerações térmicas e energéticas O suporte a CPUs de até 330W TDP, tanto em refrigeração a ar quanto líquida (D2C), demonstra que a plataforma foi projetada para operar em limites elevados de desempenho, mantendo controle térmico e estabilidade operacional. Memória DDR5 de alta densidade como pilar da virtualização Fundamentos técnicos O SYS-222HE-TN oferece 32 slots DIMM, suportando até 8TB de memória ECC DDR5 RDIMM em configuração 2DPC. Essa capacidade é um elemento central para ambientes de virtualização e software-defined storage, onde memória não é apenas suporte, mas um recurso ativo de desempenho. A operação em 6400MT/s (1DPC) ou 5200MT/s (2DPC) garante equilíbrio entre capacidade e largura de banda, permitindo ajustes finos conforme o perfil da aplicação. Impacto no negócio Alta densidade de memória reduz a necessidade de scale-out prematuro, permitindo maior consolidação de workloads por nó. Isso impacta diretamente custos de licenciamento, consumo energético e complexidade de gestão. Expansão PCIe 5.0 e aceleração de workloads Fundamentos da expansão O sistema suporta múltiplas configurações de slots PCIe 5.0, incluindo até 4 slots x16 ou 8 slots x8, além de 2 slots AIOM compatíveis com OCP NIC 3.0. Essa arquitetura viabiliza conectividade de alta largura de banda para GPUs, aceleradores e interfaces de rede avançadas. Suporte a GPUs O SYS-222HE-TN suporta até 3 GPUs double-width ou 4 GPUs single-width, com interconexão CPU-GPU via PCIe 5.0 x16. Essa capacidade é essencial para inferência de IA e machine learning em ambientes corporativos. Limitações e mitigação A utilização máxima de slots e GPUs pode exigir componentes adicionais e planejamento cuidadoso de airflow e energia. O design com até 6 ventoinhas contra-rotativas e suporte a refrigeração líquida mitiga esses riscos. Armazenamento NVMe e suporte a SDS Arquitetura de storage O servidor oferece 6 baias frontais hot-swap 2.5″ com suporte a NVMe, SAS ou SATA, além de opções para até 4 baias traseiras NVMe. Complementam essa arquitetura 2 slots M.2 NVMe PCIe 5.0 internos. O suporte a RAID via Intel VROC (com chave) amplia as opções de resiliência para workloads críticos. Impacto estratégico Essa flexibilidade permite alinhar o subsistema de armazenamento ao perfil da aplicação, seja priorizando latência mínima com NVMe ou compatibilidade com infraestruturas legadas via SAS/SATA. Governança, segurança e gestão Segurança de hardware e firmware O SYS-222HE-TN incorpora TPM 2.0 e Silicon Root of Trust compatível com NIST 800-193. Recursos como firmware assinado criptograficamente, secure boot e recuperação automática de firmware elevam o nível de proteção contra ameaças persistentes. Gestão operacional Ferramentas como SuperCloud Composer, Supermicro Server Manager e SuperServer Automation Assistant oferecem visibilidade, automação e controle centralizado, reduzindo o custo operacional ao longo do ciclo de vida do servidor. Conclusão O SuperServer SYS-222HE-TN representa uma resposta arquitetural madura às demandas contemporâneas de data centers empresariais. Sua combinação de CPUs de alta densidade, memória DDR5 escalável, expansão PCIe 5.0 e armazenamento flexível cria uma base sólida para consolidação

QNAP TS-433: cloud privada, IA embarcada e produtividade em 2.5GbE Introdução estratégica No contexto atual de trabalho híbrido, crescimento exponencial de dados pessoais e profissionais e aumento das ameaças digitais, organizações de pequeno porte, profissionais liberais e equipes distribuídas enfrentam um dilema recorrente: como manter controle total sobre seus dados sem abrir mão de desempenho, colaboração e recursos avançados de automação e inteligência artificial. Soluções exclusivamente em nuvem pública elevam custos recorrentes e criam dependência de terceiros, enquanto infraestruturas tradicionais exigem complexidade técnica e investimentos desproporcionais. É nesse cenário que o QNAP TS-433 se posiciona como uma plataforma estratégica de entrada para cloud privada e gestão inteligente de dados. Ao combinar conectividade 2.5GbE, arquitetura ARM de 64 bits, aceleração por NPU e um ecossistema de software maduro com o QTS 5, o TS-433 ultrapassa o conceito de NAS doméstico básico e passa a atender demandas reais de produtividade, segurança e automação. A inação ou a adoção de soluções inadequadas resulta em riscos claros: perda de dados por ransomware, gargalos de desempenho em ambientes colaborativos, fragmentação de backups e baixa visibilidade sobre informações críticas. Este artigo analisa de forma técnica e estratégica como o TS-433 endereça esses desafios, explorando seus fundamentos arquitetônicos, capacidades práticas e limitações, sempre conectando tecnologia a impacto direto no uso diário e no negócio. TS-433 como base de uma cloud privada moderna O problema estratégico Usuários avançados e pequenos ambientes profissionais precisam de acesso remoto confiável, sincronização de arquivos e compartilhamento seguro sem depender exclusivamente de serviços de terceiros. Plataformas públicas de cloud facilitam o acesso, mas introduzem custos crescentes, limitações de desempenho e preocupações com privacidade. Consequências da inação Sem uma cloud privada bem estruturada, dados ficam dispersos entre dispositivos, backups tornam-se inconsistentes e a colaboração depende de múltiplas ferramentas desconectadas. Isso aumenta o risco operacional e reduz a eficiência no dia a dia. Fundamentos da solução O TS-433 atua como repositório central de dados, permitindo acesso, sincronização e compartilhamento por meio do myQNAPcloud. O serviço elimina a necessidade de configurações complexas de rede, oferecendo conectividade remota segura e contínua, com um domínio dedicado e seleção automática do melhor método de conexão conforme o ambiente. Implementação estratégica Na prática, o TS-433 permite mapear pastas compartilhadas como unidades de rede, sincronizar arquivos com múltiplos dispositivos via Qsync e consolidar o acesso a documentos, fotos e projetos em um único ponto controlado. Isso cria uma experiência próxima à nuvem pública, porém com dados sob controle local. Desempenho e colaboração com 2.5GbE O problema estratégico Redes Gigabit tradicionais tornam-se gargalo em ambientes com múltiplos usuários acessando grandes volumes de dados, especialmente arquivos multimídia e backups frequentes. Fundamentos técnicos O TS-433 integra uma porta 2.5GbE e uma porta Gigabit, permitindo maior largura de banda sem exigir infraestrutura 10GbE. Em testes de laboratório, atingiu até 280 MB/s de leitura e 202 MB/s de escrita em transferências Windows sem criptografia, mantendo desempenho semelhante mesmo com criptografia AES-256 ativada. Impacto prático Esses números demonstram que o NAS sustenta fluxos de trabalho colaborativos, cópias de segurança frequentes e acesso remoto sem comprometer a experiência do usuário, desde que o ambiente de rede esteja alinhado. IA embarcada e NPU: automação prática no dia a dia O problema estratégico Organizar grandes volumes de fotos e vídeos manualmente consome tempo e reduz a produtividade. Soluções de IA em nuvem levantam preocupações com privacidade e custos. Fundamentos da solução O TS-433 incorpora uma NPU dedicada, projetada para acelerar tarefas de inteligência artificial diretamente no dispositivo. Essa arquitetura reduz a carga sobre a CPU Cortex-A55 e permite reconhecimento facial e de objetos até seis vezes mais rápido no QuMagie. Implementação prática Ao importar grandes bibliotecas de imagens, a NPU executa a classificação localmente, preservando a privacidade dos dados e garantindo respostas rápidas mesmo com hardware compacto. Proteção de dados e segurança operacional Riscos enfrentados Ameaças como ransomware, exclusões acidentais e acessos não autorizados impactam diretamente usuários e pequenos negócios. Fundamentos técnicos O TS-433 oferece snapshots como padrão, permitindo restaurar estados anteriores do sistema. Complementa-se com criptografia AES-NI 256, autenticação em dois fatores, bloqueio de IP e acesso HTTPS. Resultado estratégico Esses mecanismos elevam o nível de resiliência dos dados, aproximando o TS-433 de práticas antes restritas a ambientes empresariais. Backup como pilar central da arquitetura O TS-433 atua como hub de backup abrangente: protege PCs Windows com NetBak Replicator, sistemas macOS com Time Machine, dispositivos móveis via Qfile e QuMagie Mobile, mídias externas por One-Touch Copy e dados em nuvem por meio do Hybrid Backup Sync. Essa abordagem centralizada reduz a fragmentação e simplifica a governança de dados. Multimídia, containers e vigilância Com suporte a ARM NEON, DLNA e múltiplas plataformas de streaming, o TS-433 consolida entretenimento e produtividade. A Container Station amplia o uso para aplicações Docker, enquanto o QVR Elite viabiliza vigilância inteligente com custos controlados. Conclusão O QNAP TS-433 representa uma convergência equilibrada entre cloud privada, desempenho acessível e automação por IA embarcada. Sem prometer capacidades além de sua proposta, entrega um conjunto coerente para usuários avançados, home offices e pequenos ambientes profissionais que buscam controle, segurança e eficiência. Sua evolução natural está ligada à expansão do uso de IA on-device e redes multi-gigabit, tornando-o uma base sólida para decisões estratégicas de armazenamento e colaboração.

INTRODUÇÃO O crescimento acelerado do volume de dados não estruturados — vídeos, imagens, arquivos colaborativos e backups — tem pressionado empresas de pequeno e médio porte a repensarem sua infraestrutura de armazenamento. Ao mesmo tempo, essas organizações precisam lidar com restrições orçamentárias, ambientes híbridos e demandas crescentes por segurança, disponibilidade e desempenho. Nesse contexto, soluções rígidas e pouco escaláveis tendem a se tornar rapidamente obsoletas, gerando custos adicionais e complexidade operacional. O QNAP TS-251D surge como uma resposta arquiteturalmente flexível a esse cenário. Trata-se de um NAS que combina armazenamento seguro, gerenciamento centralizado de dados e recursos multimídia avançados, mas que se diferencia principalmente por sua capacidade de expansão via PCIe. Essa característica permite que o equipamento evolua conforme as necessidades do negócio, mitigando o risco de subdimensionamento inicial. A ausência de mecanismos adequados de proteção de dados, como snapshots, e de estratégias consistentes de backup pode expor organizações a riscos críticos, incluindo perda de informações sensíveis e impactos diretos na continuidade operacional. Além disso, a dificuldade de integrar novas tecnologias de rede ou desempenho pode limitar a vida útil de um NAS tradicional. Este artigo analisa em profundidade o QNAP TS-251D, conectando suas características técnicas — como expansão PCIe, criptografia AES-NI, snapshots, Qtier, transcodificação 4K e ecossistema QTS — aos desafios reais enfrentados por ambientes empresariais modernos. O objetivo é oferecer uma visão estratégica que apoie decisões técnicas mais seguras e sustentáveis. DESENVOLVIMENTO Expansão PCIe como resposta ao problema do crescimento imprevisível Problema estratégico Um dos maiores desafios em ambientes corporativos é prever corretamente a demanda futura por desempenho, conectividade e capacidade. NAS de entrada frequentemente se tornam gargalos quando novas aplicações exigem maior largura de banda, cache SSD ou conectividade de rede avançada, forçando substituições prematuras de hardware. Consequências da inação A falta de capacidade de expansão resulta em investimentos duplicados, janelas de migração complexas e maior risco operacional. Além disso, limita a adoção de tecnologias como 10GbE ou SSD cache, que poderiam melhorar significativamente a experiência dos usuários e a eficiência dos fluxos de trabalho. Fundamentos da solução no TS-251D O slot PCIe Gen 2.0 x4 do QNAP TS-251D permite ampliar suas funcionalidades por meio de placas de expansão compatíveis. É possível instalar placas de rede 10GbE, 5GbE ou 2.5GbE, placas QM2 para SSDs M.2 com cache e Qtier, placas USB 3.2 Gen 2 ou até placas de rede sem fio. Essa abordagem modular transforma o NAS em uma plataforma evolutiva. Implementação estratégica A expansão PCIe permite iniciar o projeto com uma configuração básica e, conforme a maturidade do ambiente, adicionar desempenho ou conectividade sem substituir o equipamento. Em cenários corporativos, isso reduz o custo total de propriedade e melhora o planejamento financeiro. Melhores práticas avançadas O uso combinado de QM2 + Qtier permite acelerar workloads frequentes sem mover dados manualmente. Já a adoção de placas 10GbE viabiliza a integração do TS-251D a redes corporativas modernas utilizando até mesmo cabeamento CAT 5e existente. Medição de sucesso Indicadores como redução de latência, aumento de throughput e menor tempo de resposta em acessos simultâneos demonstram claramente o impacto positivo da expansão PCIe no desempenho geral do sistema. Segurança de dados e proteção contra ransomware com snapshots Problema estratégico Ataques de ransomware e exclusões acidentais continuam sendo uma das principais causas de indisponibilidade de dados em empresas. Ambientes sem versionamento ou recuperação rápida ficam expostos a longos períodos de parada. Consequências da inação A ausência de snapshots pode resultar em perda definitiva de dados, custos elevados de recuperação e impactos diretos na reputação da organização. Backups tradicionais, quando usados isoladamente, nem sempre oferecem recuperação imediata. Fundamentos da solução O TS-251D oferece snapshots baseados em blocos, que registram apenas as alterações realizadas. Essa abordagem reduz consumo de espaço e acelera processos de backup e restauração, permitindo recuperar rapidamente arquivos ou volumes inteiros. Implementação estratégica O suporte a até 1.024 snapshots por NAS (no modelo TS-251D-4G) e 256 por volume ou LUN permite criar políticas de retenção adequadas para diferentes criticidades de dados, alinhando proteção e eficiência. Melhores práticas avançadas A integração de snapshots com rotinas de backup via Hybrid Backup Sync (HBS) e otimização com QuDedup cria uma estratégia de proteção em camadas, reduzindo riscos operacionais. Medição de sucesso Tempo médio de recuperação (RTO) reduzido e menor impacto em incidentes de segurança são métricas-chave para avaliar a eficácia dessa abordagem. Desempenho, criptografia e confiabilidade operacional Problema estratégico Ambientes corporativos precisam equilibrar desempenho e segurança, especialmente ao lidar com dados sensíveis. Criptografia baseada em software pode introduzir overhead significativo. Fundamentos técnicos O TS-251D utiliza um processador Intel® Celeron® J4025 dual-core, com suporte à criptografia acelerada por hardware AES-NI 256. Isso permite proteger volumes e pastas compartilhadas sem comprometer o desempenho do sistema. Evidências de desempenho Testes de laboratório da QNAP demonstram taxas de até 982 MB/s de download e 892 MB/s de upload em ambientes com 10GbE, RAID 0 e MTU 9000, evidenciando a capacidade do sistema quando corretamente configurado. Impacto no negócio A combinação de desempenho consistente e criptografia transparente garante proteção de dados sensíveis sem penalizar a produtividade dos usuários. Multimídia, transcodificação 4K e novos cenários de uso Problema estratégico Empresas que trabalham com conteúdo audiovisual, treinamento ou sinalização digital precisam de soluções que entreguem mídia em múltiplos dispositivos sem complexidade adicional. Fundamentos da solução Com Intel UHD Graphics, o TS-251D suporta decodificação e transcodificação 4K em tempo real, além de saída HDMI™, permitindo reprodução direta ou streaming via Plex Media Server e aplicações QNAP. Implementação estratégica Essa capacidade amplia o uso do NAS para além do armazenamento, permitindo aplicações como salas de treinamento, ambientes educacionais e distribuição de conteúdo corporativo. Gestão centralizada, produtividade e ecossistema QTS O sistema operacional QTS orientado a aplicativos amplia o papel do TS-251D como plataforma de produtividade. Ferramentas como File Station, Qsync, QmailAgent, Notes Station 3, Qsirch e Qfiling centralizam dados, facilitam colaboração e reduzem silos de informação. A interoperabilidade com protocolos SMB/CIFS, AFP e NFS garante integração com ambientes Windows, macOS e Linux, enquanto o acesso multiponto mantém os dados sempre sincronizados.

QNAP TS-855X: NAS 10 GbE para Virtualização e Infraestruturas Híbridas Introdução: o desafio do armazenamento empresarial moderno A evolução das infraestruturas de TI empresariais tem sido marcada por um crescimento contínuo no volume de dados, pela consolidação de workloads e pela adoção crescente de virtualização. Nesse cenário, o armazenamento deixa de ser apenas um repositório passivo e passa a desempenhar um papel estratégico na continuidade operacional, no desempenho das aplicações e na segurança da informação. Organizações que operam ambientes virtualizados, fluxos intensivos de dados ou modelos híbridos enfrentam um dilema recorrente: como equilibrar desempenho, escalabilidade e custo sem comprometer a confiabilidade. A escolha inadequada da camada de storage pode resultar em gargalos de rede, latência excessiva, janelas de backup prolongadas e maior exposição a riscos como ransomware e falhas operacionais. É nesse contexto que o QNAP TS-855X se posiciona. Trata-se de um NAS empresarial de alto desempenho, com foco em conectividade de alta velocidade, virtualização e flexibilidade arquitetural, projetado para atender projetos de médio e longo prazo. Ao longo deste artigo, analisamos de forma crítica como suas características técnicas se traduzem em valor real para ambientes corporativos. O problema estratégico: storage como gargalo em ambientes virtualizados Implicações técnicas e de negócio Em infraestruturas virtualizadas, o armazenamento é frequentemente o principal fator limitante de desempenho. Mesmo com servidores robustos, CPUs modernas e ampla memória, a experiência das aplicações degrada rapidamente quando o subsistema de storage não acompanha a demanda de IOPS e throughput. Do ponto de vista do negócio, esse gargalo se manifesta como lentidão percebida pelos utilizadores, indisponibilidade em momentos críticos e aumento do custo operacional. Projetos de virtualização mal dimensionados exigem investimentos corretivos, muitas vezes mais caros do que uma implementação adequada desde o início. Consequências da inação Ignorar a necessidade de um storage preparado para virtualização e rede de alta velocidade expõe a organização a riscos cumulativos. Backups tornam-se mais longos, a recuperação após incidentes é imprevisível e a escalabilidade passa a exigir substituições completas de hardware. Além disso, ambientes sem suporte adequado a snapshots e replicação eficiente tornam-se alvos fáceis de ransomware, aumentando o impacto financeiro e reputacional de incidentes de segurança. Fundamentos da solução: arquitetura do QNAP TS-855X Processamento e aceleração criptográfica O TS-855X é equipado com o processador Intel Atom C5125 de 8 núcleos a 2,8 GHz, uma escolha alinhada a workloads de virtualização leve a moderada e serviços de ficheiros intensivos. A presença do mecanismo AES-NI e do suporte à Intel QuickAssist Technology (QAT) reduz significativamente a sobrecarga associada à criptografia e compressão. Na prática, isso permite manter elevados níveis de desempenho mesmo com volumes encriptados ou transferências seguras, algo essencial em ambientes empresariais sujeitos a requisitos de compliance e proteção de dados. Conectividade de alta velocidade como pilar arquitetural A conectividade nativa do TS-855X inclui duas portas 2,5 GbE e uma porta 10GBASE-T, permitindo múltiplos cenários de implementação. Essa combinação oferece flexibilidade para ambientes que estão em transição para redes de maior largura de banda, sem exigir substituição imediata de toda a infraestrutura. O suporte a Multicanal SMB 3.0 permite agregar as portas de 2,5 GbE, alcançando até 5 Gb/s com tolerância a falhas, o que mitiga riscos operacionais e melhora a disponibilidade dos serviços. Implementação estratégica em ambientes empresariais Virtualização e armazenamento em bloco O TS-855X suporta LUN iSCSI baseados em blocos, oferecendo uma alternativa de storage acessível e de alto desempenho para plataformas como VMware vSphere e Microsoft Hyper-V. O suporte a VMware VAAI e Microsoft ODX permite descarregar operações intensivas do host para o NAS, reduzindo latência e melhorando a eficiência geral. Essa abordagem é particularmente relevante para organizações que desejam consolidar servidores sem investir em soluções SAN tradicionais, frequentemente mais complexas e dispendiosas. Snapshots e proteção contra ransomware Os snapshots baseados em blocos do TS-855X permitem capturar o estado de volumes e LUNs em segundos, com impacto mínimo no desempenho. Essa capacidade é fundamental para mitigar ameaças de ransomware, possibilitando a restauração rápida de dados para um ponto anterior ao ataque. A replicação de snapshots para um NAS remoto, copiando apenas as alterações, reduz o consumo de largura de banda e acelera estratégias de recuperação de desastres. QTS versus QuTS hero: decisões arquiteturais críticas QTS para flexibilidade e simplicidade O sistema operativo QTS é adequado para cenários de armazenamento híbrido HDD/SSD e sincronização de ficheiros entre equipas. Sua abordagem prioriza flexibilidade e ampla compatibilidade de aplicações. QuTS hero para integridade e eficiência de dados O QuTS hero, baseado em ZFS, introduz integridade de dados ponto a ponto e recursos avançados de redução de dados, como compressão e eliminação de duplicados inline. Essas capacidades tornam-se particularmente relevantes em ambientes empresariais onde a consistência e a fiabilidade dos dados são críticas. É importante considerar os requisitos adicionais de memória e a necessidade de planeamento cuidadoso antes da migração, dado que os sistemas de ficheiros são distintos. Escalabilidade, expansão e interoperabilidade Com duas ranhuras PCIe Gen 3 x4, o TS-855X permite expansão de rede até 25 GbE, adição de SSDs M.2 via placas QM2 ou ligação a unidades de expansão SAS e SATA. Essa flexibilidade protege o investimento inicial e permite que o NAS evolua conforme as necessidades do negócio. A interoperabilidade com ambientes Fibre Channel, através de placas opcionais, amplia ainda mais os cenários de integração, oferecendo uma alternativa economicamente viável a SANs dedicadas. Medição de sucesso e governança A eficácia da implementação do TS-855X deve ser avaliada por métricas como redução de latência em workloads virtualizados, diminuição das janelas de backup e melhoria nos tempos de recuperação. Ferramentas de monitorização de discos, como S.M.A.R.T., DA Drive Analyzer e IronWolf Health Management, contribuem para uma gestão proativa do ambiente. Em termos de governança, recursos de controlo de privilégios, autenticação reforçada e comunicações seguras ajudam a alinhar o storage com políticas corporativas de segurança e compliance. Conclusão: uma plataforma estratégica para projetos de longo prazo O QNAP TS-855X não é apenas um NAS de alto desempenho, mas uma plataforma estratégica para organizações que necessitam de flexibilidade, desempenho e fiabilidade

Introdução O crescimento exponencial do volume de dados nas organizações, aliado à necessidade de maior desempenho, segurança e flexibilidade operacional, tem pressionado pequenas e médias empresas a reavaliar suas arquiteturas de armazenamento. Soluções tradicionais baseadas exclusivamente em servidores genéricos ou storage legados frequentemente não acompanham a evolução das cargas de trabalho modernas, como virtualização, backups de máquinas virtuais, aplicações colaborativas e fluxos de dados intensivos. Nesse contexto, o NAS deixou de ser apenas um repositório de arquivos para assumir um papel estratégico dentro da infraestrutura de TI. Ele passa a atuar como elemento central de desempenho, proteção de dados e escalabilidade. O QNAP TS-473A surge exatamente nesse cenário, posicionando-se como uma plataforma flexível, capaz de evoluir conforme as necessidades do negócio. A inação ou a adoção de soluções subdimensionadas pode resultar em gargalos de desempenho, riscos de perda de dados, custos elevados de manutenção e limitações futuras de crescimento. Escolher uma plataforma inadequada compromete não apenas a eficiência operacional, mas também a capacidade da organização de responder a novas demandas. Este artigo analisa em profundidade o QNAP TS-473A, explorando sua arquitetura baseada em AMD Ryzen, conectividade Multi-Gigabit, suporte a SSD NVMe, sistemas operacionais QTS e QuTS hero, capacidades de expansão, proteção de dados e aplicações empresariais reais, sempre conectando decisões técnicas a impactos diretos no negócio. O desafio estratégico do armazenamento nas PMEs modernas Problema estratégico Empresas em crescimento enfrentam um dilema recorrente: precisam de desempenho e confiabilidade próximos aos ambientes enterprise, mas com restrições orçamentárias e equipes de TI reduzidas. Aplicações como virtualização, backups frequentes, compartilhamento de arquivos e acesso simultâneo de múltiplos usuários impõem cargas mistas de IOPS e throughput. Infraestruturas baseadas exclusivamente em 1 GbE, discos mecânicos e arquiteturas rígidas rapidamente se tornam gargalos. O resultado é latência elevada, janelas de backup prolongadas e degradação da experiência do usuário. Consequências da inação Manter uma arquitetura limitada implica em aumento do tempo de indisponibilidade, riscos operacionais e dificuldades para adotar novas soluções. Além disso, a necessidade de substituições completas em vez de expansões graduais eleva o custo total de propriedade (TCO). Fundamentos da solução O TS-473A foi projetado para oferecer uma base de hardware suficientemente robusta desde o início, mas com opções claras de expansão. Isso permite que a organização cresça de forma incremental, alinhando investimentos à evolução real do negócio. Arquitetura de processamento: AMD Ryzen V1500B Base técnica e implicações estratégicas No coração do QNAP TS-473A está o processador AMD Ryzen™ V1500B quad-core da série V1000, com até 4 núcleos e 8 threads e Turbo Core até 2,2 GHz. Essa escolha arquitetônica diferencia o equipamento de soluções baseadas em CPUs de entrada, oferecendo maior capacidade de processamento paralelo. Esse poder computacional é fundamental para lidar simultaneamente com serviços de arquivo, aplicações QPKG, virtualização, snapshots e criptografia sem comprometer o desempenho geral do sistema. Trade-offs e cenários de aplicação Embora o foco não seja cargas de IA ou HPC, o Ryzen V1500B oferece um equilíbrio sólido entre eficiência energética e desempenho, tornando o TS-473A adequado para ambientes empresariais que exigem consistência operacional. Conectividade Multi-Gigabit: 2,5 GbE como novo padrão Problema estratégico Redes baseadas exclusivamente em 1 GbE tornaram-se um gargalo evidente em ambientes com múltiplos usuários e aplicações intensivas em dados. A migração direta para 10 GbE, por outro lado, pode ser financeiramente inviável para muitas PMEs. Fundamentos da solução O TS-473A incorpora duas portas RJ45 de 2,5 GbE, permitindo ganhos imediatos de desempenho em relação ao 1 GbE tradicional, sem exigir substituição completa do cabeamento existente, já que é compatível com cabos CAT5e. Essa abordagem reduz drasticamente o custo de modernização da rede, viabilizando melhorias perceptíveis em backup, acesso a arquivos e virtualização. Interoperabilidade e escalabilidade A compatibilidade com switches Multi-Gigabit da QNAP possibilita a construção de uma infraestrutura escalável, segura e alinhada ao orçamento. SSD M.2 NVMe: cache e Qtier como aceleradores estratégicos Fundamentos técnicos O TS-473A inclui duas ranhuras SSD M.2 NVMe, permitindo a implementação de cache SSD ou da tecnologia Qtier™. Ambas as abordagens visam reduzir latência e melhorar o desempenho de IOPS, especialmente em acessos aleatórios. Cache SSD para cargas críticas A colocação em cache SSD é particularmente eficaz em ambientes de virtualização e bases de dados, onde o acesso frequente a pequenos blocos de dados pode comprometer o desempenho em discos mecânicos. Qtier como otimização contínua O Qtier™ 2.0 introduz divisão automática em camadas entre SSD M.2, SSD SATA e HDD, movendo dados conforme a frequência de acesso. A deteção de E/S em tempo real permite lidar com picos de tráfego, maximizando o retorno sobre o investimento em SSD. QTS vs QuTS hero: escolha estratégica do sistema operativo QTS: flexibilidade e simplicidade O QTS é adequado para sincronização de ficheiros, aplicações colaborativas e ambientes híbridos HDD/SSD. Sua flexibilidade o torna uma escolha prática para organizações que priorizam versatilidade. QuTS hero: integridade e proteção avançada Baseado em ZFS, o QuTS hero oferece integridade de dados ponto a ponto, snapshots avançados e redução de dados inline (eliminação de duplicados, compressão e compactação). Essas capacidades são críticas para ambientes onde a proteção de dados é prioridade estratégica. Requisitos e trade-offs O QuTS hero exige no mínimo 8 GB de memória, sendo recomendados 16 GB ou mais, especialmente quando se utilizam múltiplas aplicações ou eliminação de duplicados inline. A troca entre sistemas requer a remoção das unidades, o que demanda planejamento cuidadoso. Expansão PCIe: adaptabilidade ao longo do ciclo de vida Fundamentos da expansão Com duas ranhuras PCIe Gen 3 ×4 de baixo perfil, o TS-473A permite adicionar placas de rede 5 GbE/10 GbE, placas QM2 para SSD NVMe, placas USB 3.2 Gen 2, adaptadores Wi-Fi 6 ou controladoras SAS/SATA. Impacto estratégico Essa modularidade prolonga a vida útil do investimento, permitindo que o NAS evolua conforme novas demandas surgem, sem substituições completas. Virtualização e proteção de dados Backup de VMs com Hyper Data Protector O TS-473A suporta cópias de segurança sem agente de VMware vSphere e Microsoft Hyper-V, com backup incremental, eliminação de duplicados global, compressão e agendamento. A conectividade de 2,5 GbE reduz significativamente

Introdução À medida que as organizações dependem cada vez mais de dados para sustentar operações críticas, a infraestrutura de armazenamento deixa de ser apenas um repositório passivo e passa a desempenhar um papel central na continuidade do negócio, na virtualização, na proteção de dados e no desempenho das aplicações. Nesse contexto, soluções NAS empresariais precisam equilibrar capacidade, flexibilidade arquitetural, desempenho consistente e confiabilidade operacional. O QNAP TS-873A surge como uma resposta direta a esse cenário ao combinar um processador AMD Ryzen™ V1500B quad-core, conectividade 2,5 GbE nativa, suporte a expansão PCIe e compatibilidade com dois sistemas operativos distintos — QTS e QuTS hero. Essa combinação posiciona o equipamento não apenas como um NAS de armazenamento, mas como uma plataforma multifuncional para virtualização, backup, cache SSD e ambientes híbridos. Organizações que mantêm infraestruturas legadas baseadas em 1 GbE, discos mecânicos sem aceleração e sistemas de ficheiros sem mecanismos avançados de proteção enfrentam gargalos de desempenho, janelas de backup prolongadas e riscos elevados de integridade de dados. A inação nesse cenário resulta em custos operacionais crescentes, baixa escalabilidade e exposição a falhas difíceis de mitigar. Este artigo analisa em profundidade o QNAP TS-873A sob uma ótica técnico-estratégica, explorando sua arquitetura, opções de sistema operativo, expansão, virtualização, proteção de dados e cenários reais de aplicação empresarial, sempre conectando decisões técnicas a impactos concretos no negócio. Arquitetura do QNAP TS-873A e o desafio do desempenho empresarial Problema estratégico Ambientes empresariais modernos exigem que o armazenamento acompanhe cargas de trabalho mistas: acesso simultâneo a ficheiros, máquinas virtuais, bases de dados, backups e, em alguns casos, processamento multimédia. NAS baseados em CPUs de baixo desempenho ou com conectividade limitada tornam-se rapidamente pontos de estrangulamento. O TS-873A endereça esse desafio ao adotar o processador AMD Ryzen™ V1500B Série V1000, com até 4 núcleos e 8 threads, operando até 2,2 GHz. Essa arquitetura fornece capacidade computacional suficiente para lidar com múltiplos serviços simultâneos, incluindo virtualização, cache SSD e aplicações de backup. Do ponto de vista estratégico, a presença de um processador de classe empresarial reduz a necessidade de infraestruturas paralelas dedicadas a funções específicas, consolidando serviços e simplificando a gestão. Consequências da inação Sem uma base de processamento adequada, o crescimento natural das cargas de trabalho leva a latências elevadas, degradação do desempenho de VMs e falhas em janelas de backup. Isso impacta diretamente a produtividade das equipas e a confiabilidade das operações. Além disso, soluções subdimensionadas frequentemente exigem substituição prematura, gerando custos adicionais de aquisição e migração de dados. Fundamentos da solução O AMD Ryzen™ V1500B combina eficiência energética e capacidade multi-thread, permitindo que o TS-873A execute tarefas intensivas sem comprometer a estabilidade. O suporte a até 64 GB de memória, incluindo memória ECC, reforça a confiabilidade do sistema em cenários onde a integridade dos dados é crítica. A exigência de remoção da memória não ECC para utilização de ECC reflete uma abordagem arquitetural clara: evitar configurações híbridas que poderiam comprometer a estabilidade do sistema. Implementação estratégica Em ambientes empresariais, a adoção do TS-873A deve considerar o dimensionamento adequado de memória, especialmente quando combinado com QuTS hero, virtualização ou múltiplas aplicações QPKG. A escolha consciente da memória ECC reforça a resiliência operacional. Medição de sucesso Indicadores como estabilidade sob carga, redução de latência em aplicações simultâneas e consistência de desempenho durante backups e acessos concorrentes são métricas-chave para avaliar a eficácia dessa arquitetura. Conectividade 2,5 GbE e evolução de rede sem ruptura Problema estratégico Muitas organizações enfrentam o dilema entre permanecer em redes 1 GbE saturadas ou investir em atualizações dispendiosas de 10 GbE. Essa barreira frequentemente atrasa melhorias de desempenho necessárias. O TS-873A integra duas portas RJ45 de 2,5 GbE, retrocompatíveis com 1 GbE e 100 MbE, oferecendo uma evolução gradual e financeiramente viável. Consequências da inação Manter-se exclusivamente em 1 GbE limita severamente o aproveitamento de SSDs, cache e virtualização, tornando investimentos em hardware subutilizados. Fundamentos da solução Com suporte a Port Trunking, o TS-873A pode atingir até 5 Gb/s, permitindo ganhos imediatos de throughput sem substituição da cablagem existente. A compatibilidade com switches 2,5 GbE da QNAP facilita a adoção incremental. Implementação estratégica A estratégia recomendada envolve iniciar com 2,5 GbE para ganhos rápidos e, conforme a maturidade do ambiente, avançar para 10 GbE via placas PCIe, mantendo a longevidade do investimento. Medição de sucesso Redução do tempo de transferência de ficheiros, janelas de backup menores e melhor resposta de aplicações são métricas diretas do impacto da conectividade 2,5 GbE. Expansão PCIe como pilar de flexibilidade arquitetural Problema estratégico Ambientes empresariais raramente permanecem estáticos. Crescimento de dados, novas aplicações e mudanças de topologia exigem uma plataforma adaptável. Fundamentos da solução O TS-873A possui duas ranhuras PCIe Gen 3 ×4, compatíveis com placas de alto perfil. Isso permite adicionar 10 GbE, cache SSD adicional, Fibre Channel, USB 3.2 Gen 2, Wi-Fi 6 ou expansão SAS/SATA. Implementação estratégica Essa abordagem modular permite alinhar investimentos às necessidades reais do negócio, evitando sobreprovisionamento inicial. Pontos de falha e mitigação A escolha inadequada de placas ou a ausência de planeamento térmico pode limitar benefícios. A consulta à lista de compatibilidade é essencial. QTS vs QuTS hero: escolha estratégica do sistema operativo Problema estratégico Nem todos os workloads exigem o mesmo nível de proteção ou redução de dados. Escolher o sistema operativo inadequado pode gerar desperdício de recursos ou riscos desnecessários. Fundamentos da solução O QTS é indicado para sincronização de ficheiros e ambientes híbridos HDD/SSD. Já o QuTS hero, baseado em ZFS, oferece integridade de dados ponta a ponta, eliminação de duplicados, compressão e compactação inline. Trade-offs críticos O QuTS hero exige no mínimo 8 GB de memória, sendo recomendados 16 GB ou mais, e 32 GB para deduplicação eficiente. Além disso, a migração entre sistemas requer remoção das unidades, o que demanda planeamento rigoroso. Medição de sucesso Redução de dados efetiva, estabilidade de volumes e recuperação confiável são indicadores centrais ao adotar QuTS hero. Cache SSD, Qtier e otimização contínua do armazenamento Fundamentos da solução As duas ranhuras M.2 NVMe do TS-873A permitem cache SSD ou tecnologia

Introdução A transformação digital acelerou de forma decisiva a complexidade das redes empresariais. Organizações modernas operam simultaneamente com aplicações críticas, múltiplas filiais, trabalhadores remotos, dispositivos IoT e volumes crescentes de dados armazenados em NAS corporativos. Nesse cenário, o router deixou de ser apenas um elemento de conectividade e passou a desempenhar um papel estratégico na continuidade operacional, na segurança e na eficiência do negócio. O QHora-322 surge como resposta direta a esse novo paradigma. Posicionado como um router SD-WAN de próxima geração, ele combina portas de alta velocidade 10 GbE e 2,5 GbE com uma arquitetura de encaminhamento totalmente definida por software, integrada nativamente ao ecossistema QuWAN SD-WAN da QNAP. Essa combinação reflete uma mudança estrutural: da gestão manual e fragmentada para um modelo centralizado, automatizado e orientado à segurança. As organizações que mantêm infraestruturas de rede tradicionais enfrentam riscos claros: gargalos de desempenho, elevada complexidade operacional, dificuldades de expansão multilocal e exposição crescente a ataques cibernéticos. A ausência de segmentação adequada, de redundância de WAN e de túneis VPN bem geridos resulta frequentemente em interrupções de serviço e perdas operacionais. Este artigo analisa de forma aprofundada o QHora-322 sob a perspetiva estratégica e técnica, contextualizando seus fundamentos, implicações práticas, cenários de uso empresarial e integração com NAS QNAP, IoT e ambientes distribuídos, sempre conectando as decisões tecnológicas aos impactos reais no negócio. O desafio estratégico das redes empresariais modernas Fragmentação, desempenho e risco operacional À medida que empresas expandem operações para múltiplos locais, a rede passa a ser um dos principais fatores de risco operacional. Infraestruturas baseadas em routers convencionais, configurados manualmente e sem inteligência de tráfego, não acompanham a dinâmica atual de aplicações distribuídas e fluxos de dados intensivos. Ambientes com NAS empresariais, videovigilância, sistemas POS, ERP e acesso remoto exigem largura de banda elevada, latência previsível e segurança consistente entre todos os pontos da rede. Sem esses requisitos, a experiência do utilizador degrada-se, os tempos de resposta aumentam e processos críticos tornam-se vulneráveis. Além disso, a gestão descentralizada de VPNs e políticas de firewall cria inconsistências de segurança. Cada novo local ou colaborador remoto adiciona complexidade, aumentando a probabilidade de falhas de configuração e brechas exploráveis. Consequências da inação A manutenção de uma arquitetura de rede tradicional implica custos ocultos elevados. Interrupções de conectividade entre filiais, falhas em backups remotos e lentidão na replicação de dados afetam diretamente a continuidade dos negócios. Do ponto de vista de segurança, a ausência de segmentação e de um modelo Zero Trust expõe NAS, dispositivos IoT e sistemas internos a ataques laterais, ransomware e acessos não autorizados. Esses riscos são amplificados quando o acesso remoto cresce sem uma estratégia SD-WAN bem definida. Fundamentos técnicos do QHora-322 Arquitetura de portas e desempenho com fios O QHora-322 disponibiliza três portas de 10 GbE e seis portas de 2,5 GbE, permitindo uma implementação altamente flexível de WAN e LAN. Cada porta é, por predefinição, independente, o que representa uma mudança importante face aos routers tradicionais com portas rigidamente agrupadas. Essa abordagem orientada por software possibilita que cada interface seja definida conforme a necessidade do negócio, seja para ligações WAN de alta velocidade, LANs dedicadas ou segmentos isolados para IoT. A compatibilidade multi-speed (10G/5G/2,5G/1G/100M) assegura interoperabilidade com infraestruturas existentes. O suporte a PPPoE de 10 GbE com desempenho superior a 9 Gb/s posiciona o QHora-322 num patamar de conectividade normalmente reservado a ambientes empresariais de maior escala, garantindo capacidade suficiente para aplicações intensivas e backups contínuos. Encaminhamento definido por software O modelo de encaminhamento do QHora-322 é totalmente controlado pelo SO QuRouter. Em vez de configurações estáticas e complexas, a segmentação de rede, a atribuição de portas e as políticas de tráfego são definidas de forma lógica e adaptável. O suporte a encaminhamento baseado em políticas e rotas estáticas permite direcionar tráfego conforme IP de origem, aplicação ou dispositivo. Essa granularidade é essencial para otimizar fluxos, evitar congestionamentos e garantir previsibilidade de desempenho. SD-WAN e VPN mesh com QuWAN VPN mesh automatizada A tecnologia QuWAN SD-WAN estabelece automaticamente uma VPN em rede mesh segura entre dispositivos QNAP em múltiplos locais. Essa automatização elimina a necessidade de configurações manuais complexas, reduzindo drasticamente o tempo de implementação. Ao adicionar o QHora-322 ao QuWAN Orchestrator, o sistema configura rotas e túneis VPN de forma centralizada. Isso viabiliza uma arquitetura multilocal consistente, onde sede, filiais e até NAS remotos comunicam-se como se estivessem na mesma rede lógica. Escalabilidade e alta disponibilidade O QHora-322 suporta até 1000 ligações VPN simultâneas, refletindo uma capacidade alinhada a ambientes empresariais com grande número de utilizadores remotos ou dispositivos conectados. Funcionalidades como agregação de WAN dupla, balanceamento de carga e ativação pós-falha asseguram continuidade operacional. Em caso de falha de uma ligação, o tráfego é automaticamente redirecionado, minimizando impactos nos serviços críticos. Integração estratégica com NAS e backup seguro Proteção do NAS e acesso remoto O emparelhamento do QHora-322 com um NAS QNAP é fortemente recomendado para cenários empresariais. Ao posicionar o router à frente do NAS, a tradução de endereços de rede (NAT) oculta o IP real do dispositivo, reduzindo a superfície de ataque. Essa arquitetura protege não apenas NAS QNAP, mas também dispositivos de outros fabricantes, criando uma camada adicional de segurança perimetral. Backups remotos e air-gap Com o uso do Hybrid Backup Sync através do QuWAN, é possível transferir ficheiros e snapshots entre vários NAS por meio de uma rede encriptada. Isso viabiliza estratégias de backup remoto seguras, fundamentais para continuidade de negócios. O suporte à solução Airgap+ permite isolar logicamente redes de backup, protegendo dados contra ransomware e vazamentos. Esse modelo de isolamento representa uma evolução importante face a backups tradicionais sempre online. Segmentação, IoT e governança de rede Segmentação VLAN e IoT O QHora-322 permite a criação de múltiplos segmentos VLAN, separando aplicações, dispositivos IoT e sistemas críticos mesmo quando partilham a mesma infraestrutura física. A conectividade direta de dispositivos IoT em segmentos independentes reduz riscos de movimentação lateral e garante que dispositivos heterogéneos possam coexistir sem comprometer a segurança. Governança e controlo de aplicações A firewall L7

ASUSTOR Drivestor 2 (AS1102T): análise técnica estratégica para ambientes SMB Introdução No cenário atual de pequenas e médias empresas, escritórios distribuídos e ambientes SOHO profissionalizados, o armazenamento deixou de ser apenas uma questão de capacidade. Ele se tornou um eixo crítico de continuidade operacional, segurança da informação e eficiência de processos. O crescimento de dados não estruturados, a dependência de arquivos digitais e a necessidade de acesso remoto seguro colocam pressão direta sobre soluções de armazenamento tradicionalmente simplificadas. Dentro desse contexto, soluções NAS de entrada precisam entregar mais do que preço competitivo. Elas devem equilibrar desempenho de rede, confiabilidade 24/7, mecanismos de proteção contra perda de dados e uma camada de software capaz de sustentar backup, sincronização e segurança sem exigir infraestrutura complexa. É exatamente nesse ponto que o ASUSTOR Drivestor 2 (AS1102T) se posiciona. Ignorar essas demandas ou adotar soluções subdimensionadas expõe organizações a riscos concretos: indisponibilidade de arquivos críticos, perda de dados por ransomware, gargalos de rede e custos indiretos associados à recuperação manual ou retrabalho. A escolha inadequada de um NAS pode transformar economia inicial em prejuízo operacional. Este artigo analisa o ASUSTOR Drivestor 2 (AS1102T) sob uma perspectiva técnica e estratégica, utilizando exclusivamente as informações oficiais fornecidas pela ASUSTOR. O objetivo é compreender não apenas o que o equipamento oferece, mas por que sua arquitetura, recursos de software e posicionamento fazem sentido para determinados cenários empresariais. O desafio estratégico do armazenamento em SMBs Problema estratégico Empresas de pequeno e médio porte frequentemente operam com equipes reduzidas de TI ou até sem profissionais dedicados. Ainda assim, lidam com volumes crescentes de dados, múltiplos dispositivos, trabalho remoto e exigências mínimas de segurança e compliance. O desafio central é adotar uma solução de armazenamento que seja robusta, mas operacionalmente simples. Modelos tradicionais de servidores ou soluções puramente em nuvem nem sempre atendem a esse equilíbrio. Servidores exigem manutenção, energia e conhecimento especializado, enquanto a nuvem pode introduzir custos recorrentes, dependência de conectividade e limitações de performance para grandes volumes locais. O NAS surge como alternativa intermediária, mas somente quando oferece recursos de rede, proteção e software adequados. Caso contrário, torna-se apenas um repositório passivo de arquivos. Consequências da inação Sem uma solução estruturada, dados críticos acabam dispersos em PCs, notebooks e dispositivos móveis. Isso dificulta backups consistentes, aumenta a superfície de ataque e compromete a recuperação em caso de falha ou ataque de ransomware. A ausência de controle centralizado também impacta diretamente a produtividade. Arquivos duplicados, versões inconsistentes e acessos inseguros tornam-se rotina, elevando custos operacionais invisíveis. Fundamentos da solução com o Drivestor 2 O ASUSTOR Drivestor 2 foi concebido para atuar como ponto central de dados em ambientes que exigem simplicidade sem abrir mão de desempenho básico e segurança. Sua arquitetura combina hardware eficiente com o sistema operacional ADM 4.0, baseado em Linux, que integra proteção, backup e gerenciamento. O uso de Ethernet 2,5 Gigabit, CPU quad-core de 64 bits e memória DDR4 demonstra uma preocupação clara em eliminar gargalos comuns em NAS de entrada baseados em Gigabit e arquiteturas antigas. Arquitetura de hardware e implicações práticas CPU Realtek RTD1296 Quad-Core 1,4 GHz O Drivestor 2 utiliza o processador Realtek RTD1296, um SoC quad-core de 64 bits operando a 1,4 GHz. Essa escolha arquitetônica prioriza eficiência energética e capacidade de multitarefa suficiente para serviços simultâneos como transferência de arquivos, backup e streaming. Em termos práticos, isso permite que o NAS execute transcodificação de mídia 4K com decodificação de hardware, ao mesmo tempo em que mantém operações de rede estáveis. Para ambientes SMB, isso significa que tarefas multimídia ou de acesso remoto não precisam competir agressivamente por recursos. O trade-off dessa arquitetura está no foco claro em workloads leves a moderados. O Drivestor 2 não foi projetado para virtualização pesada ou bancos de dados transacionais, mas entrega estabilidade consistente dentro de seu escopo. Memória DDR4 e Modo de Mídia Equipado com 1 GB de memória DDR4, o Drivestor 2 se beneficia de um padrão de memória até 40% mais eficiente que gerações anteriores. A eficiência energética e a largura de banda contribuem para maior estabilidade em multitarefa. O recurso Modo de Mídia reserva 512 MB de RAM exclusivamente para tarefas multimídia. Essa separação lógica reduz interferências entre serviços, garantindo reprodução de vídeo contínua mesmo quando o NAS executa outras operações. Do ponto de vista estratégico, essa abordagem demonstra uma otimização orientada a uso real, mitigando limitações naturais de capacidade de memória por meio de gestão inteligente. Ethernet 2,5 Gigabit como diferencial estrutural A adoção de Ethernet 2,5GbE posiciona o Drivestor 2 acima da maioria dos NAS de entrada baseados em Gigabit. Em testes internos de laboratório da ASUSTOR, o equipamento alcança até 215 MB/s de leitura e 270 MB/s de escrita em RAID 1. Esses números reduzem significativamente janelas de backup e tempos de transferência, especialmente em ambientes com múltiplos usuários. Mesmo em redes mistas, o investimento em 2,5GbE prepara a infraestrutura para crescimento futuro. É importante considerar que tais desempenhos dependem de clientes e rede compatíveis, reforçando a necessidade de alinhamento entre NAS e infraestrutura existente. Sistema operacional ADM 4.0: impacto além da interface Fundamentos e melhorias estruturais O ADM 4.0 representa mais do que uma atualização estética. Ele incorpora melhorias de desempenho, compatibilidade e segurança, incluindo versões atualizadas do OpenSSL para mitigação de vulnerabilidades conhecidas. A nova interface, com modo escuro e elementos personalizáveis, reduz fadiga visual e melhora a experiência administrativa, especialmente em operações recorrentes. A pesquisa rápida e a nova página de login aumentam eficiência operacional, reduzindo tempo de configuração e resposta. Segurança integrada e governança básica O Drivestor 2 se beneficia de um conjunto integrado de segurança: firewall embutido, ADM Defender, ClamAV Antivirus, criptografia AES-256 por pasta, autenticação em duas etapas e conexões VPN com SSL. Esses mecanismos atendem necessidades reais de SMBs, oferecendo camadas defensivas contra ataques de rede e ransomware sem exigir soluções externas complexas. Recursos como logout automático e controle granular de acesso reforçam governança mínima de dados, essencial para ambientes com múltiplos usuários. Estratégia de backup e proteção

GIGABYTE AI TOP ATOM: O supercomputador pessoal de IA para desenvolvimento avançado Introdução A computação de alto desempenho voltada para Inteligência Artificial vive um ponto de inflexão. Até recentemente, a capacidade de treinar modelos avançados ou executar pipelines completos de IA dependia, quase exclusivamente, de grandes clusters, data centers especializados ou infraestruturas de cloud computing. Esse modelo impunha uma série de desafios: custos recorrentes elevados, latência imprevisível, barreiras de segurança e limitações de personalização. Nesse cenário, surge o GIGABYTE AI TOP ATOM, uma proposta singular que redefine o conceito de workstation ao trazer, para a mesa de trabalho do desenvolvedor, capacidades antes restritas a supercomputadores corporativos. Com arquitetura baseada no NVIDIA GB10 Grace Blackwell Superchip, desempenho de 1 petaFLOP, memória 128GB unificada e integração com a pilha completa NVIDIA AI, o AI TOP ATOM inaugura uma nova categoria: o supercomputador pessoal de IA. Essa mudança estrutural redefine prioridades técnicas, reduz dependências externas e permite ciclos de desenvolvimento mais rápidos, seguros e econômicos. Para empresas e profissionais que trabalham com modelos generativos, análise de dados ou aplicações de borda, essa evolução representa uma mudança estratégica com impacto direto em competitividade e inovação. Ao longo deste artigo, analisaremos em profundidade a arquitetura, o desempenho, os cenários de aplicação e os impactos operacionais do GIGABYTE AI TOP ATOM. Também exploraremos riscos de inação, práticas de implementação, alinhamento com governança corporativa e perspectivas futuras. A partir dessa análise, fica claro que o AI TOP ATOM não é apenas uma ferramenta — é uma plataforma capaz de transformar a forma como organizações desenvolvem, testam e implantam soluções avançadas de IA. O Problema Estratégico: A necessidade de computação de IA de alta performance local Limitações de modelos tradicionais de desenvolvimento de IA O desenvolvimento moderno de IA exige capacidade computacional massiva, especialmente em áreas como modelos generativos, visão computacional e análise multimodal. Infraestruturas baseadas em cloud, embora amplamente utilizadas, enfrentam limitações críticas: custos imprevisíveis, latência elevada, dependência de acesso externo e desafios de privacidade de dados. Equipes que precisam iterar rapidamente em modelos ou realizar experimentos sensíveis enfrentam atrasos contínuos que comprometem eficiência e capacidade de resposta ao mercado. Além disso, a natureza iterativa do desenvolvimento de IA demanda ciclos curtos de experimentação. Restrições impostas por ambientes remotos ou compartilhados frequentemente tornam esse processo mais lento e caro. O cenário se agrava quando empresas precisam treinar modelos proprietários com dados internos — situação na qual questões de compliance, confidencialidade e soberania de dados se tornam fundamentais. Escassez de recursos computacionais especializados A crescente complexidade dos modelos também pressionou o acesso a GPUs de alta performance. Organizações menores ou equipes independentes enfrentam longas filas em provedores de nuvem e custos elevados para acessar hardware de nova geração. Isso impõe desigualdade competitiva entre grandes corporações e times menores, limitando a capacidade de inovação e experimentação. O GIGABYTE AI TOP ATOM surge para preencher justamente essa lacuna: disponibilizar uma infraestrutura de altíssimo desempenho inteiramente local, sem dependências externas, com baixo consumo energético e formato compacto. Consequências da Inação: Riscos estratégicos e operacionais Perda de competitividade no ciclo de inovação Empresas sem capacidade computacional local robusta tendem a perder velocidade em seus ciclos de pesquisa e desenvolvimento. A dependência exclusiva de cloud cria gargalos que impactam diretamente a capacidade de iterar, testar hipóteses, realizar tuning e prototipar soluções. Isso resulta em decisões mais lentas e menor competitividade frente a concorrentes com infraestrutura moderna e distribuída. Exposição a riscos de segurança e compliance A transferência de dados sensíveis para ambientes externos é uma preocupação crescente, especialmente em setores como saúde, finanças e indústria. Cada movimentação para a nuvem envolve riscos: vazamentos, interceptação, falhas de isolamento e violações normativas. A ausência de uma plataforma local para execução de modelos e experimentos acentua esse risco. Custos operacionais superiores Dependência exclusiva de cloud computing resulta em custos variáveis difíceis de prever — especialmente quando cargas de trabalho aumentam ou se tornam contínuas. Treinar modelos grandes pode gerar despesas que ultrapassam rapidamente orçamentos projetados. Manter capacidades de IA local reduz essa volatilidade e dá previsibilidade ao planejamento financeiro. Fundamentos da Solução: A Arquitetura do GIGABYTE AI TOP ATOM O papel do NVIDIA GB10 Grace Blackwell Superchip O núcleo do GIGABYTE AI TOP ATOM é o NVIDIA GB10 Grace Blackwell Superchip, uma solução que unifica CPU e GPU em arquitetura de alto desempenho capaz de entregar 1 petaFLOP em FP4 para cargas de trabalho de IA. Essa capacidade coloca o dispositivo na mesma categoria de supercomputadores corporativos, mas em formato reduzido e sem necessidade de infraestrutura especializada. Ao combinar um CPU Arm de 20 núcleos (10 Cortex-X925 + 10 Cortex A725) com a nova arquitetura NVIDIA Blackwell, o sistema equilibra tarefas tradicionais de processamento com aceleração massiva de IA. Essa simbiose é fundamental para pipelines completos que envolvem preparação de dados, inferência, fine-tuning e deploy. Memória unificada de 128GB: implicações estratégicas A memória unificada LPDDR5x de 128GB é um dos elementos mais estratégicos da plataforma. Diferentemente de sistemas tradicionais, que separam memória de CPU e GPU, o AI TOP ATOM oferece um único pool coerente, eliminando transferências redundantes e melhorando drasticamente a eficiência e velocidade no treinamento e inferência. Na prática, isso significa manipular modelos de até 200 bilhões de parâmetros e, quando conectado a outro sistema via NVIDIA ConnectX-7, alcançar suporte para modelos de até 405 bilhões de parâmetros. Essa capacidade muda a dinâmica de processamento local e expande o escopo de aplicações possíveis. NVLink-C2C: conectividade de alto desempenho A tecnologia NVIDIA NVLink-C2C permite comunicação de baixa latência entre os componentes internos do superchip. Isso reduz gargalos e permite que workloads mais sensíveis a latência consigam operar de forma contínua e previsível. Do ponto de vista arquitetônico, essa característica reforça o posicionamento do AI TOP ATOM como plataforma para cargas de IA de alta intensidade. Armazenamento NVMe Gen5 de até 4 TB Com suporte a armazenamento NVMe Gen5 de até 4 TB, o AI TOP ATOM oferece throughput robusto para manipulação de grandes conjuntos de dados e modelos volumosos. O suporte a autocriptografia reforça

ASUSTOR AS6806T Gen3: desempenho empresarial, segurança e arquitetura avançada O ASUSTOR AS6806T Gen3 representa uma evolução marcante dentro do universo NAS profissional, reunindo uma arquitetura centrada em desempenho, segurança e eficiência operacional. Estruturado sobre um processador AMD Ryzen Embedded V3C14, memória ECC DDR5 e múltiplos vetores de aceleração, o AS6806T emerge como um dispositivo projetado para enfrentar cenários empresariais de alta exigência, onde estabilidade, velocidade e proteção de dados são imperativos. Este artigo aprofunda-se nas dimensões estratégicas, técnicas e operacionais do equipamento, explorando suas implicações diretas em ambientes corporativos, criativos e híbridos. Introdução: O papel estratégico do AS6806T no cenário empresarial moderno Organizações modernas lidam com uma explosão de dados que não apenas cresce em volume, mas também em diversidade e criticidade. Workloads distribuídas, migração para arquiteturas híbridas, exigências de segurança e fluxos de trabalho de mídia profissional criam um cenário no qual um simples repositório de arquivos não é mais suficiente. É nesse contexto que o AS6806T se posiciona como uma plataforma multifuncional, integrando desempenho computacional, largura de banda, proteção de dados e ecossistema de aplicações. Os desafios que empresas enfrentam ao armazenar, proteger e disponibilizar dados em escala envolvem riscos diretos — perda de informações, interrupções operacionais, superfícies de ataque expandidas e limitações de desempenho que comprometem produtividade e competitividade. A inação ou adoção de soluções genéricas resulta em gargalos que impactam diretamente equipes de TI, operações e áreas de negócios que dependem de acesso rápido e consistente a informações. Ao longo deste artigo, investigaremos profundamente como o AS6806T aborda esses desafios através de sua combinação de hardware avançado, suporte a criptografia pós-quântica, mecanismos de backup híbrido, resfriamento otimizado e integração com nuvem, segurança e sistemas de vigilância. O Desafio Estratégico: Por que o armazenamento exige novas arquiteturas A escalabilidade como desafio central Setores como mídia digital, segurança corporativa, pequenas empresas e equipes criativas convivem diariamente com cargas crescentes de dados, frequentemente não estruturados. Vídeos em alta resolução, imagens RAW, bancos de dados de aplicações de grande porte e repositórios de projetos colaborativos exigem arquiteturas capazes de lidar com múltiplas camadas de acesso simultâneo. O AS6806T não atua apenas como um repositório, mas como uma plataforma orientada à performance. Seu processador Ryzen Embedded de quatro núcleos, com frequências que variam entre 2,3 e 3,8 GHz, fornece o poder necessário para operações de criptografia, transcodificação, backup e acesso paralelo sem gerar gargalos associados a processadores de entrada. Os limites de plataformas tradicionais Soluções de armazenamento baseadas em hardware limitado sofrem com latência elevada, degradação de desempenho sob carga e ausência de mecanismos nativos de proteção. Em vez de agir como catalisadores da operação, tornam-se fontes de interrupção e risco. É nesse aspecto que a arquitetura moderna do AS6806T se destaca: memória ECC, SSDs NVMe PCIe 4.0, portas USB4 e multiplicidade de conexões multigigabit oferecem não apenas desempenho bruto, mas consistência — o que é essencial em ambientes onde a previsibilidade operacional é tão crítica quanto a velocidade. Consequências da inação: riscos técnicos e de negócio Ignorar a necessidade de dispositivos robustos de armazenamento gera impactos diretos sobre governança, continuidade operacional e segurança da informação. Perda de dados e interrupções Sem mecanismos como ECC, snapshots ou criptografia forte, o risco de corrupção ou perda de dados se amplia exponencialmente. A exposição a falhas elétricas, interferências magnéticas ou erros de memória pode comprometer bases de dados inteiras ou arquivos de projetos críticos. O AS6806T trata esse risco com memória ECC DDR5-4800 e Snapshot Center com até 256 versões por volume. Superfícies ampliadas para ataques Com ransomware e ameaças cada vez mais sofisticadas, a falta de plataformas preparadas para ameaças modernas leva a incidentes que comprometem reputações e operações. O AS6806T oferece camadas como PQC Hybrid TLS, firewall, antivírus ClamAV, MyArchive com criptografia AES-256 e autenticação em duas etapas. Limitações operacionais Workflows de mídia moderna, backup híbrido, vigilância IP e virtualização leve exigem desempenho sustentado. Ambientes equipados com hardware desatualizado acumulam atrasos, perda de produtividade e dependência de nuvem em cenários onde o custo por gigabyte se torna proibitivo. Fundamentos técnicos da solução ASUSTOR AS6806T Arquitetura Ryzen Embedded V3C14 O processador Ryzen Embedded fornece uma base estável, eficiente e projetada para cargas de trabalho 24/7. Com quatro núcleos e velocidades de até 3,8 GHz, ele combina desempenho desktop com eficiência térmica. Essa arquitetura traz vantagens claras em transcodificação, manipulação de dados, criptografia e suporte a aplicações paralelas. Memória ECC DDR5: integridade como prioridade A memória ECC — típica de servidores — detecta e corrige erros comuns antes da gravação, evitando perdas silenciosas. Em ambientes corporativos, essa capacidade torna-se crucial, principalmente quando se lida com operações contínuas de backup, processamento de grandes volumes de mídia e vigilância. PCI Express 4.0: aceleração da camada de armazenamento Os quatro slots NVMe M.2 PCIe 4.0 dobram o desempenho em relação à geração anterior. A combinação de SSDs NVMe com o ADM habilita cache de leitura e escrita, além de camadas híbridas de armazenamento capazes de suportar aplicações intensivas em IOPS. USB4 e Thunderbolt: largura de banda extrema Com duas portas USB4 a 40 Gbps, o AS6806T se posiciona entre os dispositivos NAS mais rápidos do mercado em conectividade externa. Embora a CPU Ryzen Embedded V3000 não permita conexões host-to-host, o suporte a dispositivos de armazenamento USB4, Thunderbolt 3 e 4 amplia significativamente as possibilidades de ingestão e exportação de dados. Conectividade multigigabit: 10GbE e 5GbE Com duas portas 10GbE e duas portas 5GbE, o AS6806T permite arquiteturas de rede avançadas, incluindo SMB Multichannel e agregação inteligente, alcançando até 1693 MB/s de leitura em RAID 5. Sistema avançado de resfriamento Tubos de calor e aletas otimizam dissipação térmica, garantindo estabilidade mesmo durante workloads intensos, algo essencial em ambientes onde a confiabilidade 24/7 é mandatória. Implementação estratégica do AS6806T em ambientes corporativos Proteção avançada de dados com PQC Hybrid TLS A adoção do algoritmo Kyber (X25519+ML-KEM 768) protege contra ataques de futura computação quântica. O recurso é ativado de forma automática no ADM 5.1 ou superior, garantindo segurança forward-looking sem necessidade de ajustes manuais. Backup híbrido e